今天,在这篇文章中,让让我们来谈谈计算能力。

近两年,计算能力可以说是ICT行业的一个热门概念。总是出现在新闻报道和大咖演讲中。

那么,到底什么是计算能力呢?包括哪几种力,它们的用途是什么?目前全球计算能力发展如何?

接下来,正文开始。

什么是计算能力

众所周知,计算的字面意思是计算能力。

更具体地说,计算能力是通过处理信息数据实现目标结果输出的计算能力。

我们人类其实就有这种能力。在我们的一生中,我们无时无刻不在计算。我们的大脑是一个强大的计算引擎。

很多时候,我们会通过口算和心算来做无工具计算。不过这种算力有点低。所以在遇到复杂情况时,我们会使用力计算工具进行深度计算。

在古代,我们原始的工具是草绳和石头。后来随着文明的进步,我们有了更实用的计算幂的工具,如算盘(一种计算用的小棍)、算盘等,计算幂的水平不断提高。

在20世纪40年代,我们迎来了计算能力的革命。

1946年2月,世界上第一台数字电子计算机ENIAC诞生,标志着人类计算能力正式进入数字电子时代。

后来随着半导体技术的出现和发展,我们进入了芯片时代。芯片已经成为计算能力的主要载体。

时间在流逝。

到了70-80年代,芯片技术在摩尔的法律。芯片的性能在不断提高,体积在不断减小。最后,电脑已经小型化,PC(个人电脑)诞生了。

PC的诞生意义深远。标志着IT计算能力不再仅仅服务于少数大型企业(大型机),而是走向普通家庭和中小企业。它成功地打开了全民信息时代的大门,促进了全社会信息的普及。

借助PC,人们充分感受到IT计算能力带来的生活质量和生产力的提升。PC的出现也为互联网的蓬勃发展奠定了基础。

进入21世纪后,计算能力再次迎来巨变。

这一巨变的标志就是云计算技术的出现。

在云计算出现之前,人类苦于单点计算(一台大型机或一台PC,独立完成所有计算任务)的计算能力不足,曾尝试网格计算等分布式计算架构(将一个巨大的计算任务分解成许多小的计算任务,交给不同的计算机完成)。

云计算是分布式计算的新尝试。其本质是将大量分散的计算资源进行封装和聚集,以实现更高的可靠性、更高的性能和更低成本的计算能力。

具体来说,在云计算中,中央处理器(CPU)、内存、硬盘和显卡(GPU)等计算资源聚集在一起,形成一个虚拟的无限扩展计算资源池通过软件的方式。

如果用户有计算能力的需求,计算能力资源池会动态分配计算能力资源,用户按需付费。

与用户相比设备自购,自建机房,自主运营,云计算性价比优势明显。

继云计算之后,数据中心已经成为计算能力的主要载体。人类计算能力的规模开始了新的飞跃。

计算能力分类

云计算和数据中心的出现是因为信息化和数字化的不断深入,引发了全社会对计算能力的强烈需求。

这些需求不仅来自消费领域(移动互联网、追剧、网购、打车、O2O等。),也来自行业板块(工业制造、交通物流、金融证券、教育医疗等)。),以及来自城市治理板块(智慧城市、一卡通、城市大脑等)。).

不同的计算应用和要求有不同的算法。不同的算法对计算能力的特性有不同的要求。

通常,我们会划分计算能力

大家应该都听说过,负责输出计算能力的芯片分为通用芯片和专用芯片。

像x86这样的CPU处理器芯片是通用芯片。它们能完成的计算任务多样灵活,但功耗较高。

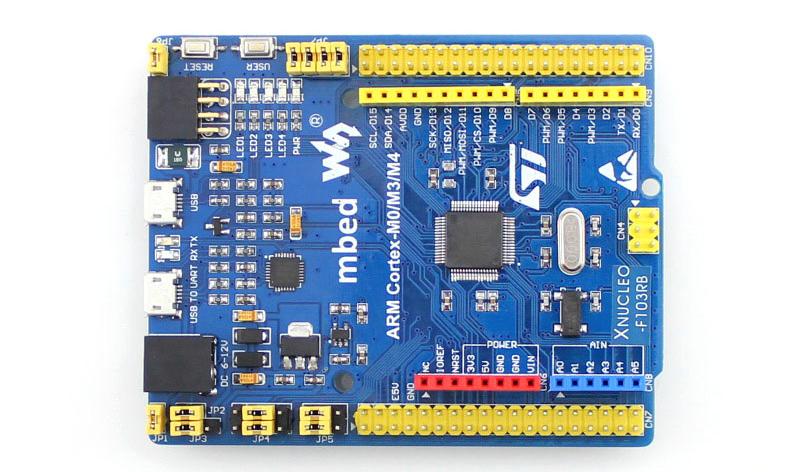

专用芯片主要指FPGA和ASIC。

FPGA是一种可编程集成电路。它可以通过硬件编程改变内部芯片的逻辑结构,但软件是深度定制的,以执行特殊任务。

ASIC是一种专用集成电路。顾名思义,就是专业使用的定制芯片,其软件算法大部分固化在硅片中。

ASIC可以完成特定的计算功能,功能比较单一,但是能耗很低。FPGA,介于通用芯片和ASIC之间。

以比特币挖矿为例。

以前人们用PC(x86通用芯片)挖矿。后来越是难挖,计算能力越少。于是,我开始用显卡(GPU)挖矿。后来显卡能耗太高,挖出来的钱值不了电费,就用FPGA和ASIC集群阵列挖矿。

在数据中心,计算任务也分为基础通用计算和HPC高性能计算。

HPC继续细分为三个类别:

科学计算:物理化学、气象环保、生命科学、石油勘探、天文勘探等。

工科:计算机辅助工程、计算机辅助制造、电子设计自动化、电磁仿真等。

计算类:AI(人工智能)计算,包括机器学习、深度学习、数据分析等。

科学计算和工程计算大家应该都听说过。这些专业科研领域产生大量数据,对计算能力要求极高。

以油气勘探为例。油气勘探,简单来说就是在地表做CT。一个项目之后,原始数据往往超过100TB,甚至可能超过1 PB。如此庞大的数据量,需要海量的计算能力来支撑。

为了智能地计算这个,我们需要关注它。

AI人工智能是目前全社会重点关注的发展方向。不管是哪个领域,都在研究人工智能的应用和落地。

人工智能的三大核心要素是计算能力、算法和数据。

众所周知,AI人工智能是计算能力很大的,尤其是吃计算能力。在人工智能计算中,矩阵或向量的乘法和加法比较多,特异性高,不适合CPU计算。

在实际应用中,人们主要使用GPU和前面提到的专用芯片进行计算。尤其是GPU是目前AI算力的主力。

GPU虽然是图形处理器,但是GPU核心(逻辑运算单元)的数量远远超过CPU,因此适合将同一指令流并行发送到多个核心,使用不同的输入数据执行,从而完成图形处理或大数据处理中的海量简单运算。

所以GPU更适合处理计算密集型和高度并行的计算任务(比如AI计算)。

近年来,因为对人工智能计算的强烈需求,国家也专门建设了许多智能计算中心,即专门用于智能计算的数据中心。

除了智能计算中心,还有很多超级计算中心。在超级计算机中心里,有像天河一号,致力于各种大规模科学计算和工程计算任务。

我们平时看到的数据中心基本都属于云计算数据中心。

任务复杂,既有基本的通用计算和高性能计算,也有大量的异构计算(同时使用不同指令集的计算方法)。因为对高性能计算的需求越来越大,专用计算芯片的比例也在逐渐增加。

几年前逐渐流行起来的TPU、NPU、DPU,其实都是专用芯片。

如今,我们经常听到计算能力卸载。其实并不是删除计算能力,而是转移很多计算任务(比如虚拟化、数据转发、压缩存储、加密解密等。)从CPU到NPU、DPU等芯片,从而降低计算po

近年来,科学界除了基本的通用计算力、智能计算力和超级计算力之外,还出现了以量子计算和光子计算为主的前沿计算力的概念,值得关注。

计算能力的度量

因为武力是一种能力当然,也会有衡量其实力的指标和标杆单位。熟悉的单位应该是FLOPS,TFLOPS等。

其实衡量计算能力的指标有很多,比如MIPS、DMIPS、OPS等。

MFLOPS、GFLOPS、TFLOPS、PFLOPS等。都是不同数量级的失败。具体关系如下:

浮点数有不同的规格FP16、FP32、FP64。

不同的计算能力载体,计算能力存在巨大差异。有关详细信息,请参见下表:

我们前面提到了通用计算、智能计算和超级计算。从趋势上看,智能计算和超级计算能力的增长速度远远超过一般计算能力。

根据GIV的统计,到2030年,通用计算能力(FP32)将增加10倍,达到3.3万亿次。AI智能计算能力(FP16)将增加500倍,达到105次浮点运算。

计算能力的现状和未来

早在1961年,人工智能之父约翰麦卡锡就提出了效用计算的目标。他相信:有一天,计算可能被组织成一种公用事业,就像电话系统是公用事业一样。

现在,他的想法变成了现实。在数字化浪潮下,计算能力已经像水、电一样成为公共基础资源,而数据中心和通信网络也成为重要的公共基础设施。

这是IT行业和通信行业半个多世纪努力的结果。

对于整个人类社会来说,计算能力已经不是一个技术维度的概念。它已经上升到经济学和哲学的维度,成为数字经济时代的核心生产力,也是整个社会数字化智造转型的基石。

每个人的生活,以及工厂企业的运作,政府部门的运作,都可以与计算能力分不开。国家安全、国防建设、基础学科研究等关键领域也需要大量的计算能力。

计算决定了数字经济的发展速度和社会智能化的发展高度。

根据IDC、浪潮信息和清华大学全球产业研究院联合发布的数据,计算力指数每提高1点,数字经济和GDP将分别增长3.5和1.8。

各国计算能力的规模与经济发展水平之间存在显著的正相关关系。一个国家的计算能力越大,经济发展水平就越高。

世界计算能力和GDP排名

(来源:迟在华为计算时代峰会上的演讲)

在计算能力领域,国与国之间的竞争日趋激烈。

2020年,我国计算能力总规模达到135 EFLOPS,同比增长55%,高于全球增速约16个百分点。目前,我们的绝对计算能力排名世界第二。

但从人均来看,我们并不占优,只是处于中等计算能力国家的水平。

世界各国人均计算能力比较

(来源:唐在华为计算时代峰会上的演讲)

特别是在芯片等算力核心技术上,我们和发达国家还有很大差距。很多瓶颈技术没有解决,严重影响了我们的计算安全,从而影响到国家安全。

所以还有很长的路要走,还需要继续努力。

未来,信息化、数字化、智能化将进一步加快。随着万物互联时代的到来,大量智能物联网终端的引入和AI智能场景的落地,将会产生难以想象的海量数据。

这些数据将进一步刺激对计算能力的需求。

根据罗兰贝格预测,从2018年到2030年,自动驾驶的计算能力需求将增长390倍,智能工厂的需求将增长110倍,主要国家的人均计算能力需求将增长20倍,从今天的不足500 GFLOPS到2年的10000 GFLOPS

比如计算能力的利用率,计算能力分配的均衡性。IDC数据显示,目前企业中分散的计算能力利用率只有10%-15%,这是一种极大的浪费。

摩尔定律在2015年开始放缓,单位能耗计算能力的增速已经被数据量的增速逐渐拉大。我们在不断挖掘芯片计算能力潜力的同时,必须考虑计算能力的资源调度。

那么,我们如何安排计算能力呢?现有的通信网络技术能否满足计算能力的调度要求?

编辑:李倩